整理了chatgpt微调所需要的测试资源数据,按照fine-tuning的格式生成的数据集。可以直接 fine_tunes.create -t 使用。 微调完毕后可以 -p 回答结果。 其中包含三四百条数据。 适合测试openai自定义模型的人群使用。

”openai chatgpt chatgpt微调 openai微调 fine-tuning“ 的搜索结果

Java调用openai微调Fine-tuning实战示例

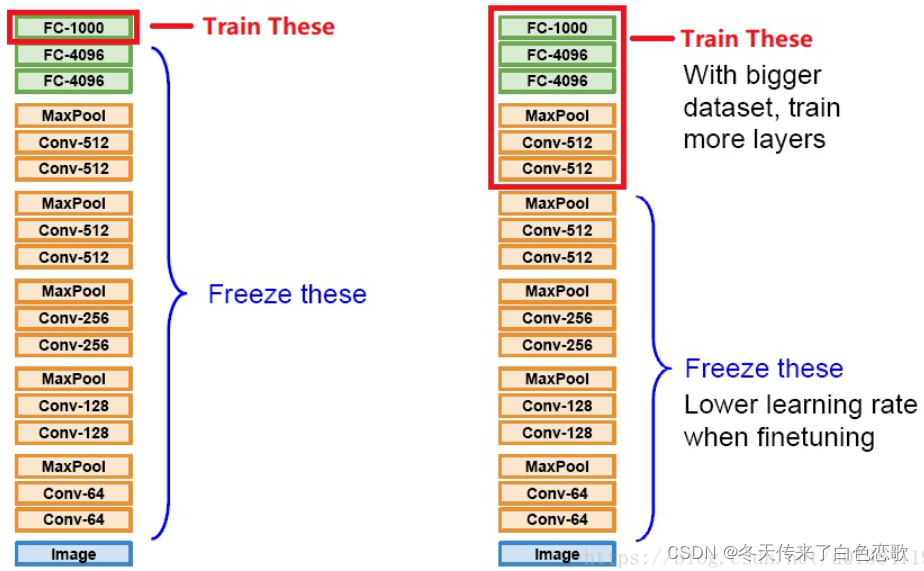

Fine-tuning是机器学习和深度学习中的一个术语,简称微调,指的是在一个预训练模型的基础上进行的再训练过程。在微调的过程中,通常会冻结(即不更新)模型的某些层,特别是那些学习到通用特征的底层,而只更新模型...

了解大语言模型的参数高效微调(Parameter-Effcient Fine-Tuning)

3.在仍然需要Fine-Tuning的情况下,最初的prompt-engineering不会浪费,在微调数据中使用好的prompt(或者将prompt chaining/tool和Fine-Tuning结合),有助于我们看到最好的结果。如果您已经优化过prompt,模型依然有...

GPT推出了Fine-tune微调模型,让我们可以基于自己的数据,对GPT进行微调训练。这里不讲述概念,因为网上都是概念,这里直接上实操。下面我们根据Openai官方文档,来做基于gpt-3.5-turbo进行微调训练。

目前诸如GPT、Llama等大型AI模型通常具有非常大的参数量,要想将其迁移到具体的下游场景任务中,利用重头训练的全局微调变得十分昂贵,对于普通研究者明显不现实,为此Microsoft提出了一种低消耗的大模型微调方法—...

微调fine-tuning.pdf微调fine-tuning.pdf微调fine-tuning.pdf微调fine-tuning.pdf

做一个不十分准确的对比,对比一个人的学习过程,预训练有点像学校学习,从小学一直到本科、硕士、博士等,SFT有点像进入单位的短期实习,RLHF有点像单位的规章制度学习,告诉你什么可以做什么不能说,要尊敬领导...

要使用OpenAI的微调技术来训练自己的专有模型,您需要遵循以下步骤:获取和准备数据集:首先,您需要准备自己的数据集。可以使用公共数据集,也可以使用自己的数据集。数据集需要以特定格式(如JSONL)进行存储,...

而从generative pre-training(生成式预训练)到discriminative fine-tuning(判别微调)的过程是一个对泛化特征进行面向任务的特化的过程。对于初始化过程,我们可以称自己的网络为目标网络,训练好的模型对应网络...

随着大模型的飞速发展,在短短一年间就有了大幅度的...我们总结了算法工程师需要掌握的大模型微调技能,并制作了大模型微调技能图谱,希望可以帮助大家将知识体系梳理清楚,为未来在大模型的工作与科研道路上节省时...

分析微调的优势

网址:https://platform.openai.com/finetune选择其中心血管科中的部分数据进行微调 微调需要进行付费,越多收费越多,并且的数最多为dataframe导入csv文件 提取样本 jsonl格式数据构建 jsonl数据导出 点击...

chatgpt微调/fine-tuning测试资源 整理了chatgpt微调所需要的测试资源数据,按照fine-tuning的格式生成的数据集。可以直接 fine_tunes.create -t 使用。 微调完毕后可以 -p 回答结果。 其中包含三四百条数据。 适合...

探索未来预训练模型微调的新方式:Prompt-Tuning 项目地址:https://gitcode.com/google-research/prompt-tuning ...传统上,我们通过Fine-Tuning整个模型来适应特定任务,而Prompt-Tuning则专注于调整输入提...

因此,许多研究表明,精心设计的适应性架构微调的有效性。然而,新问题出现,如何找到最优的适应性策略?本文,通过神经架构搜索(NAS)来回答这个问题。给定一个预训练神经网络,该算法能找到一个适应器的最优排列...

微调(Fine-tuning)是指在深度学习领域中,特别是针对预训练模型的一种训练策略。预先训练好的模型通常是在大规模无标注数据上通过自监督学习得到的,它们具有对一般自然语言结构的良好理解能力。微调则是指在预...

Transformers 提供了一个Trainer类,帮助你在自己的数据集上微调它提供的预训练模型。在完成了上一节中的所有数据预处理工作后,定义Trainer只需要几步。最难的部分可能是准备运行的环境,因为它在 CPU 上运行会非常...

为了增强大型语言模型(LLM)对下游任务的适应性,通常需要进行微调。尽管如此,更新数十亿个参数的过程需要大量的计算资源和训练时间,这对大规模模型在各种场景中的广泛应用构成了重大障碍。为了解决这个问题,...

微调通过训练比提示中更多的示例来改进小样本学习,让您在大量任务中取得更好的结果。对模型进行微调后,您将不再需要在提示中提供示例。这样可以节省成本并实现更低延迟的请求。Visit our请访问我们的定价页面,...

微调数据上传成功之后,开始使用,使用时,你会发现model只有 danvici 可选,danvici003啥的都不行。这里,要在 计算机管理中 跟设置java ...openAi fine-tuning 尝鲜结束。这里一次不能成功,得根据提示,多次上传。

近年来,迁移学习改变了自然语言处理领域的范式,对预训练语言模型(PLM)进行微调(fine-tuning)已经成为了新的范式。本文主要梳理了近期的预训练语言模型做fine-tuning的进...

迁移学习中的微调(Fine-tuning)是指在已经预训练好的模型基础上,对部分或全部模型参数进行调整以适应新任务。微调是在预训练模型的基础上进一步训练模型,使其适应新的任务或数据集。

俄语文本摘要的GPT-3微调_Fine-tuning GPT-3 for Russian Text Summarization.pdf

上一步提交完训练任务之后,模型是需要一段时间来训练的,训练的时长取决于你的数据量大小、当下训练的任务数、openai的算力是否充足等等。像使用基础模型gpt-3.5,gpt-4一样,但这个模型名字是你自己训练的,所以...

大模型微调技术(Adapter-Tuning、Prefix-Tuning、Prompt-Tuning(P-Tuning)、P-Tuning v2、LoRA)

在深度学习过程中,获取数据集后,在训练自己的网络之前,用别人现有的网络进行fine-tuning(微调),然后训练。在实践中,由于数据集不够大,很少有人从头开始训练网络,常见的做法是使用预训练的网络来重新fine-...

推荐文章

- 阿里云企业邮箱的stmp服务器地址_阿里云stmp地址-程序员宅基地

- c++ 判断数学表达式有效性_高考数学大题如何"保分"?学霸教你六大绝招!...-程序员宅基地

- 处理office365登录出现服务器问题_o365登陆显示网络异常-程序员宅基地

- Nginx RTMP源码分析--ngx_rtmp_live_module源码分析之添加stream_ngx_rtmp_live_module 原理-程序员宅基地

- 基于Ansible+Python开发运维巡检工具_automation_inspector.tar.gz-程序员宅基地

- Linux Shell - if 语句和判断表达式_shell if elif-程序员宅基地

- python升序和降序排序_Python排序列表数组方法–通过示例解释升序和降序-程序员宅基地

- jenkins 构建前执行shell_Jenkins – 在构建之前执行脚本,然后让用户确认构建-程序员宅基地

- 如何完全卸载MySQL_mysql怎么卸载干净-程序员宅基地

- AndroidO Treble架构下HIDL服务查询过程_found dead hwbinder service-程序员宅基地